這是我的第349篇專欄文章。

生成式人工智能GenAI是否存在泡沫?這個問題日益成為業界熱議的焦點。目前,全球對AI基礎設施的投資已到了癲狂的成千上萬億美元的規模,然而大模型如何實現盈利卻始終沒有一個明確的答案。

在眾說紛紜之際,有一個領域的潛力卻常常被低估,那就是邊緣側的人工智能(Edge AI)。作為一個方興未艾的領域,邊緣AI與云端AI可謂迥然不同。那些在數據中心行之有效的方法,不一定能夠適用于工業邊緣平臺,如安全攝像頭、機械臂或汽車等場景。

由于空間限制、功耗、預算、數據安全以及實時性等要求,邊緣AI領域沒有一刀切的解決方案。這意味著,沒有任何一種方案能夠滿足所有人工智能應用的需求,從云端AI過渡到邊緣AI需要開發全新的模型。

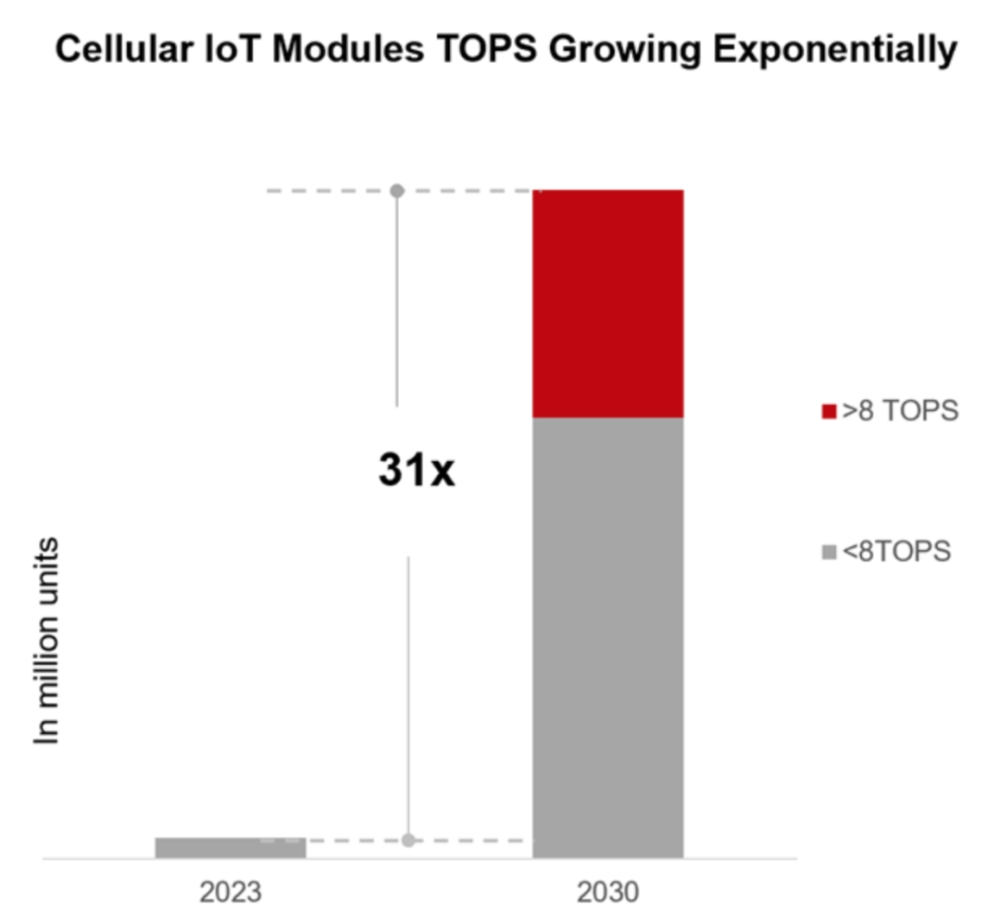

研究機構Counter Points的數據顯示,未來AIoT模塊的計算能力將實現指數級的大幅增長。據測算,未來七年內配備神經網絡處理單元NPU的模塊數量將達到目前的31倍,這將催生大量創新應用的涌現。

面對如此蓬勃發展的邊緣AI市場,本文將對其進行深入剖析。筆者認為,邊緣AI的崛起將催生出全新的商業模式,而去中心化物理基礎設施網絡DePIN或許是幫助邊緣AI避免盈利困境的有效解決方案之一。

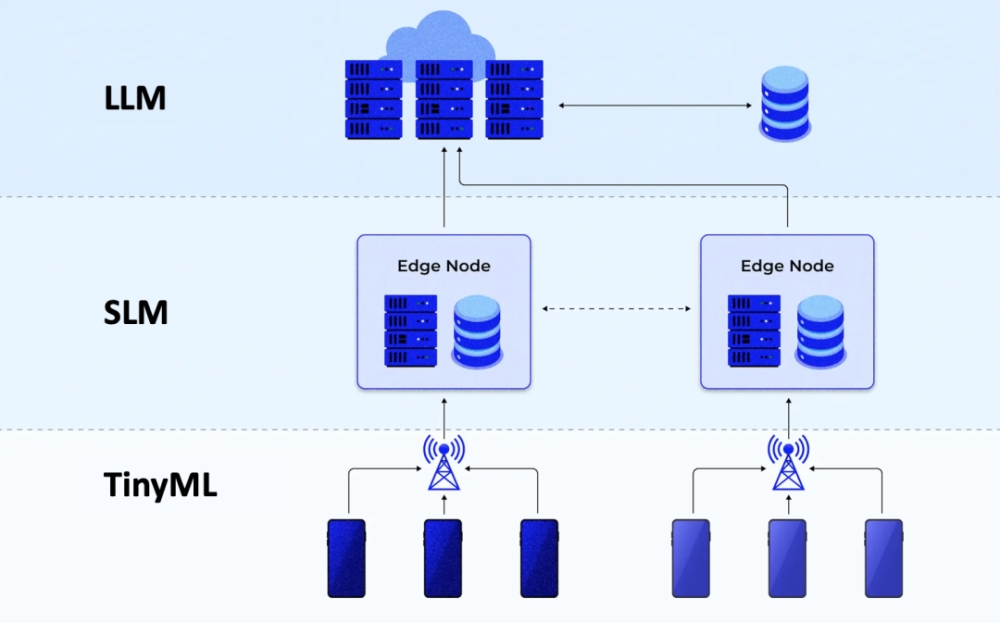

TinyML、SLM與LLM:聯合語言模型的“三駕馬車”

在人工智能的世界里,終端側、邊緣側和云端扮演著截然不同的角色。它們在形態、功能和應用場景上的差異如此之大,以至于可以將其視為完全不同的實體。

正是基于這種認識,有業界人士提出了“聯合大模型”的理念,旨在將不同規模的AI模型分別部署于云、邊、端三個層面,以執行相關任務。

在終端側,微型機器學習(TinyML)正在崛起。TinyML是一種優化機器學習模型的技術,使其能夠在資源受限的設備(如微控制器)上高效運行。這些模型通常體積小巧、運算高效,能夠勝任語音識別和傳感器數據分析等任務。

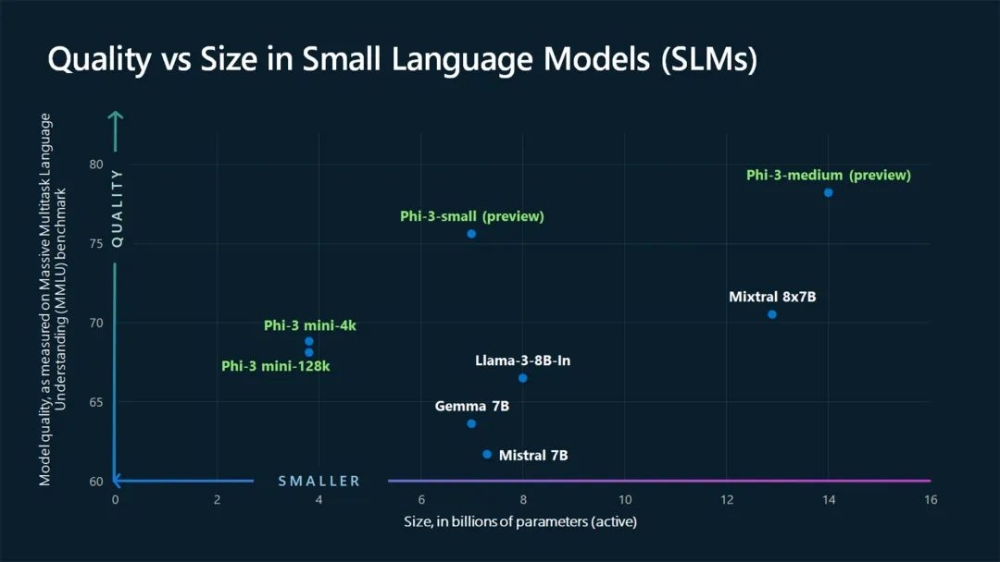

邊緣側的主角則是小型語言模型(SLM)。SLM指的是那些參數量低于100億的輕量級神經網絡模型。與大型模型相比,SLM以更少的參數和計算資源實現自然語言處理(如下圖所示)。此外,SLM通常是面向特定任務、應用或用例量身定制的。

至于云端,大型語言模型(LLM)無疑是其中的佼佼者。LLM是一種強大的深度學習算法,能夠執行各種自然語言處理(NLP)任務。得益于海量訓練數據和多個Transformer模型的使用,LLM具備了識別、翻譯、預測乃至生成文本等內容的驚人能力。

“聯合語言模型”的提出,正是為了充分利用TinyML、SLM和LLM這三種技術,在保障隱私性和安全性的同時,為企業帶來切實價值。

TinyML以其超低成本和功耗的特點,非常適合在資源有限的設備(如物聯網終端和可穿戴硬件)上使用。

而SLM可以看作是LLM的“迷你版”。相比動輒數百萬、數十億參數的GPT-4等大型模型,SLM的運行規模要簡單得多。經過優化的SLM能夠高效處理較為簡單的任務,而無需消耗大量計算資源。

盡管規模不及LLM,SLM在實際應用中卻有著不可小覷的作用。從文本生成、問答到語言翻譯,SLM能夠勝任多種任務,只是在準確性和多功能性上可能稍遜一籌。

SLM的優勢還體現在其訓練速度快、推理速度佳等方面。它在性能和資源效率之間取得了微妙的平衡。參數數量的減少,使得SLM的訓練更加經濟高效;而將處理工作負載轉移到邊緣設備,則進一步降低了基礎設施和運營成本。

BrainChip公司的實踐表明,綜合利用TinyML和SLM能夠取得顯著成效:模型參數數量減少50倍,訓練時間縮短30倍,多重累積運算(MAC)降低5000倍,而精度卻保持不變甚至有所提高。性能和功耗效率的提升與模型效率成正比。

Tirias Research預測,如果到2028年,使用邊緣設備和終端硬件內的TinyML和SLM混合處理,從數據中心卸載20%的LLM工作負載,那么數據中心基礎設施和運營成本將下降150億美元,整體功耗需求也將降低800兆瓦。

從云端到邊緣:GenAI遷移的必經之路

隨著人工智能技術的不斷發展,越來越多的AI模型開始從云端數據中心向邊緣設備遷移。這種趨勢的背后,是成本、實時性和安全性等因素的綜合考量。

在云端運行AI模型,盡管能夠利用數據中心強大的算力資源,但往往面臨著高昂的費用、網絡延遲和數據安全隱患等問題。相比之下,通過模型壓縮等優化技術,將神經網絡模型部署在網絡邊緣設備上運行,即邊緣計算,則有望在保證性能的同時,大幅降低成本和延遲,提高數據安全性。

然而,對于許多邊緣應用場景而言,簡單地將數據中心的解決方案“縮小”并非最佳選擇。在醫療保健、汽車、制造等關鍵領域,邊緣AI應用通常專注于傳感器數據的實時處理,對模型的尺寸、精度和執行效率有著更高的要求。

這就催生了“EdgeGenAI”的概念,即在設備上執行的生成式AI。越來越多的硬件展示了EdgeGenAI的能力,高通、英偉達等芯片廠商紛紛展示了在移動端運行Stable Diffusion、LLaMA等模型的可能性,這預示著EdgeGenAI已經到來。

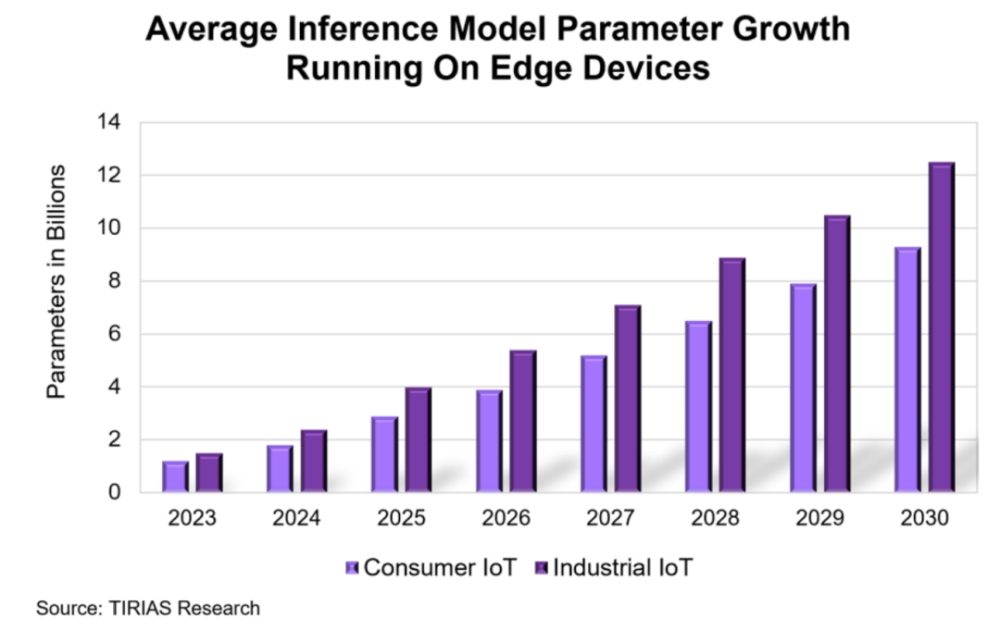

根據Tirias Research的分析,隨著AI模型的不斷壓縮優化以及終端和邊緣設備算力的持續提升,越來越多的GenAI模型將能夠在設備端完成推理和執行。這意味著,適用于端側處理的模型規模將隨時間推移而不斷增加,設備本地的AI處理能力將不斷拓展。

與此同時,消費類和工業物聯網設備所承載的平均推理模型參數規模也在不斷增長。為了評估GenAI的發展前景和總體擁有成本TCO,Tirias Research對不同類別的設備進行了細分和建模,如下圖所示。

研究發現,在設備本地處理AI任務,不僅能夠顯著降低響應延遲,提升用戶體驗,還能夠有效緩解數據隱私和安全問題。通過減少或消除與云端的數據交互,敏感數據和GenAI生成的結果都能夠在設備層得到妥善保護,大大降低了隱私泄露和網絡攻擊的風險。

不過,并非所有GenAI應用都適合完全在設備上處理。受限于芯片算力、內存容量和功耗預算,許多大型模型仍然無法在單個設備上高效執行。

針對這一問題,“聯合大模型”的提出恰逢其時。

通過在設備與云端之間合理分配計算任務,這種混合計算模式能夠在降低延遲、保護隱私的同時,充分利用云端的算力優勢。

例如,在圖像生成應用中,初始圖像可以在設備上快速生成,而后續的增強和優化則交由云端處理。在需要整合多源數據的場景,如實時地圖更新,將本地信息與云端模型結合也能發揮協同效應。某些涉及專有數據的行業應用,如工業和醫療領域,出于安全考慮,也可能需要在云端完成部分敏感計算任務。

據此,邊緣AI有望迎來爆發式增長,據Counter Point預測,到2030年,搭載AI算力的物聯網模塊將占整體出貨量的25%,遠高于2023年的6%。

在汽車領域,AI助手通過語音交互、導航引導和娛樂控制,正在重塑自動駕駛體驗;在零售行業,搭載AI模塊的智能POS終端憑借掌紋或人臉識別、行為分析等能力,助力客戶洞察、庫存管理和風險防控;在智能家居場景,集成AI功能的路由器有望成為照明、安防、能源管理等子系統的中樞。此外,無人機、工業手持設備、服務機器人等領域,也將成為邊緣AI芯片的主要應用陣地。

DePIN賦能邊緣AI,開創盈利新模式

在人工智能的商業化進程中,大型語言模型(LLM)的盈利之路一直備受關注。

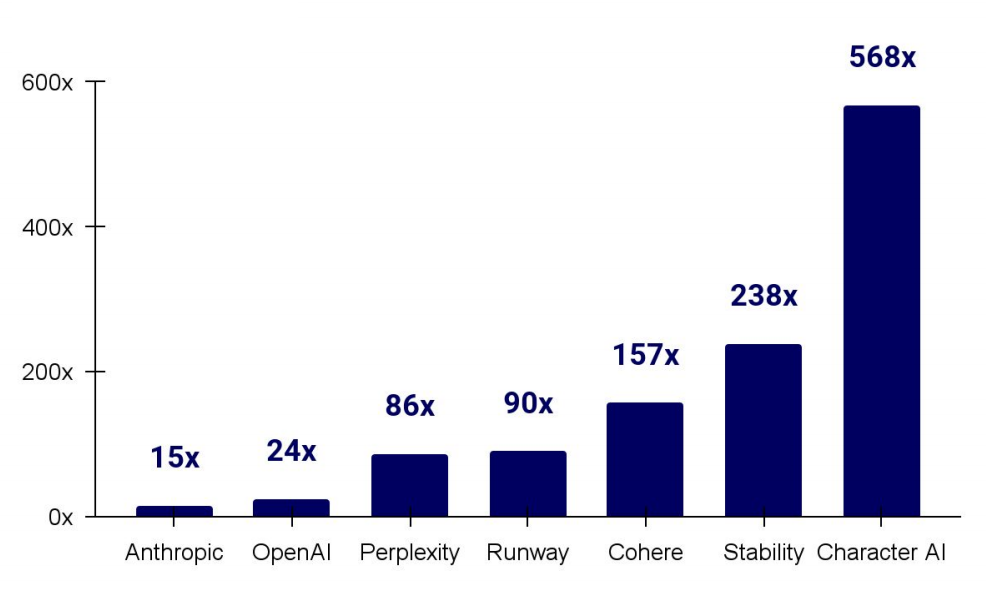

盡管生成式AI初創企業頻頻獲得高額融資,估值屢創新高(如下圖所示),但如何將技術優勢轉化為持續穩定的收入,仍是一個懸而未決的難題。

與此同時,隨著AI模型不斷向邊緣遷移,嵌入式AI設備的市場需求正在快速增長。在這一背景下,去中心化物理基礎設施網絡(DePIN)與邊緣AI的結合,有望為這一難題提供一個全新的解決思路。

DePIN的核心理念,是通過區塊鏈技術和token經濟,將分散在全球各地的物理設備連接起來,形成一個去中心化的資源共享網絡。在這個網絡中,設備所有者可以將閑置的計算、存儲、帶寬等資源出租給需求方,從而獲得token激勵。而需求方則可以以更低的成本、更高的靈活性,獲得所需的基礎設施服務。

如果將DePIN的模式引入邊緣AI領域,可以極大地促進AI設備的普及和應用。

一方面,設備制造商可以通過融入DePIN社區,將AI設備預置到去中心化網絡中,以資源共享的方式銷售設備使用權,而非一次性售賣硬件產品。這種“設備即服務”的模式,將大大降低用戶的前期采購成本,提升邊緣AI的易用性。

另一方面,AI模型提供商也可以利用DePIN網絡,將訓練好的模型以API的形式提供給設備所有者,并按照調用量獲得token收益。這種按需付費的機制,將顯著降低邊緣AI的推理成本,使中小企業和個人開發者也能夠負擔得起高質量的AI服務。

某寵物智能項圈廠商的案例,為DePIN賦能邊緣AI提供了一個生動的例證。該廠商計劃將智能項圈引入DePIN社區,構建一個去中心化的寵物數據共享網絡。憑借項圈內置的活動監測和定位跟蹤功能,海量的寵物行為數據將被采集和流轉,成為寵物AI模型訓練的重要數據源。而寵物主人則可以選擇性地共享這些數據,并獲得token激勵。

這一去中心化AI范式,不僅能夠顯著提升數據處理的實時性和隱私性,更能夠為寵物AI模型的開發和優化提供源源不斷的數據支持。

與此同時,該廠商還計劃開放項圈的邊緣算力,允許第三方開發者將寵物AI模型部署到項圈中,實現場景化的AI應用,如異常行為檢測、情緒識別、安全區域預警等。這種“AI即插即用”的開放生態,將極大地釋放邊緣AI的想象空間,催生出一批以寵物為中心的創新應用和服務。

DePIN與邊緣AI的結合,不僅為設備制造商開辟了新的銷售渠道和盈利模式,也為AI企業搭建了一個海量數據聚合、模型快速部署的去中心化基礎設施。

寫在最后

隨著TinyML、SLM等技術的成熟,AI模型正在從云端向邊緣大規模遷移,催生出EdgeGenAI等全新的應用形態。通過模型壓縮、混合計算等優化手段,百億級參數模型已經能夠在智能手機等終端設備上高效運行。在萬物智聯的時代,邊緣AI將為汽車、零售、家居等行業賦能,創造巨大的商業價值。

不過,當前的邊緣AI生態仍面臨著設備成本高、開發門檻高、盈利模式單一等挑戰。去中心化物理網絡DePIN的引入,有望通過將AI設備接入資源共享網絡,建立按需付費機制,構建開放生態,從而有效破解邊緣AI的商業化困局。

參考資料:

Federated Language Models:SLMs at the Edge + Cloud LLMs,作者:Janakiram MSV,來源:thenewstack.io

Tiny but mighty:The Phi-3 small language models with big potential,作者:Sally Beatty,來源:微軟