在上一篇文章《從附加功能到重構(gòu)產(chǎn)品價值,端側(cè)AI將重新定義可穿戴設(shè)備》中曾提到過智能終端正在利用本地側(cè)AI來提升終端產(chǎn)品附加值,并逐步通過軟硬件協(xié)同將AI從“附加功能”推向“重構(gòu)核心能力”,轉(zhuǎn)移設(shè)備價值重心,最終端側(cè)AI將成為智能終端設(shè)備的定義者。

從生成式AI的云端智能到端側(cè)AI落地的革命漫長的技術(shù)周期里,上下游廠商不斷探索著硬件創(chuàng)新、端側(cè)算法模型優(yōu)化與場景落地的協(xié)同。那當(dāng)AI走出云端落到端側(cè)如何才能讓終端設(shè)備真正“智能”?Deepseek的橫空出世給出了一份答案。Deepseek展現(xiàn)的“低成本、高性能、開源”顛覆性優(yōu)勢,直接點亮了終端側(cè)AI的發(fā)展前景,端側(cè)智能不再完全受限于硬件算力與能效,大模型通過蒸餾技術(shù)重構(gòu)的小模型在端側(cè)部署可行性大增。

從已發(fā)布的多個Deepseek R1的精簡模型來看,在保持性能的前提下,能將模型參數(shù)量大幅壓縮,這使得端側(cè)模型部署難度顯著減小,并突破以往端側(cè)AI面臨存儲空間、算力消耗、推理延遲等部署障礙。知名分析師郭明錤日前也發(fā)文指出,Deepseek爆紅后,端側(cè)AI趨勢將加速。

端側(cè)應(yīng)用的想象空間的確在Deepseek的加持下不斷擴(kuò)大,特別是在今年端側(cè)AI元年這個時間節(jié)點,AI模組廠商紛紛布局Deepseek,幫助下游終端客戶搭建本地智能。模組與Deepseek的融合,這意味著產(chǎn)業(yè)鏈下游的中小型廠商能夠通過模組快速集成AI能力推出各自的終端產(chǎn)品。可以說AI模組正在破局DeepSeek在實體產(chǎn)業(yè)落地的最后一公里,AI也將在今年快速向終端普及。

Deepseek正在成為端側(cè)AI新引擎

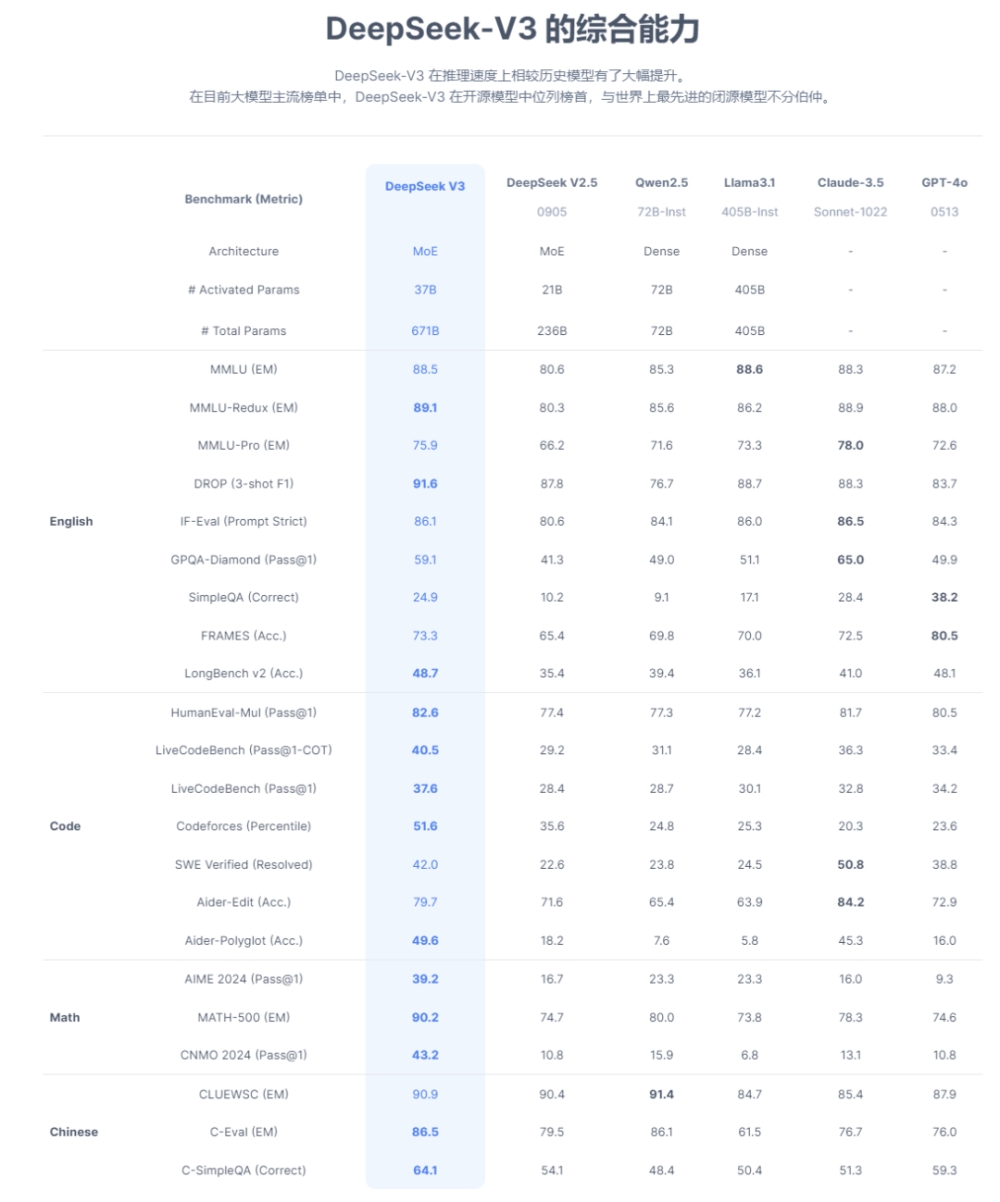

自Deepseek成為整個科技圈關(guān)注的焦點,上到芯片廠商、模組廠商下到軟件廠商、方案廠商以及再到垂直應(yīng)用的終端廠商,都在爭先恐后加入Deepseek生態(tài)圈。這一全球現(xiàn)象級的模型到底有何特別之處,特別對于端側(cè)應(yīng)用來說,Deepseek給出了哪些不同以往模型的支持?

圖源:Deepseek

首先是模型的輕量化設(shè)計,Deepseek采用自研的DeepseekMoE架構(gòu),和傳統(tǒng)的MoE架構(gòu)相比,減少專家間的知識冗余,并通過稀疏混合專家(Sparse Mixture of Experts)層替代傳統(tǒng)Transformer的前饋網(wǎng)絡(luò)(FFN),每個Token僅激活少量專家,大幅減少計算量和顯存占用。

這一輕量化設(shè)計最直接的體現(xiàn)就是671B參數(shù)的模型實際激活參數(shù)量僅37B,顯著降低推理資源需求。這意味著AI能夠在計算資源有限的終端設(shè)備上運行,支持從超大規(guī)模模型到端側(cè)設(shè)備的無縫擴(kuò)展,在手機、PC、ARVR等可穿戴設(shè)備、汽車等端側(cè)硬件本地化部署上具有很強的可操作性。

其次,大模型推理過程KV 機制是限制推理效率的一大瓶頸,Deepseek創(chuàng)新的MLA機制通過低秩聯(lián)合壓縮鍵值(KV)緩存,相比傳統(tǒng)MHA減少約90%的KV緩存量,提升推理效率。MLA在保持性能的同時,減少對顯存帶寬的依賴,實現(xiàn)更徹底的輕量化,更適合端側(cè)設(shè)備部署。

在模型蒸餾和本地部署上,Deepseek本身就提供了不少蒸餾版模型,如R1的1.5B版本,全面支持在資源受限硬件中運行。例如PC僅需1.1GB內(nèi)存即可完成基礎(chǔ)推理任務(wù),極大擴(kuò)展了AI的應(yīng)用場景。

第二是Deepseek在低功耗上的優(yōu)化。在并行計算與通信優(yōu)化上大幅減少了功耗。Deepseek采用DualPipe流水線并行技術(shù),通過重疊前向傳播與后向傳播的計算和通信階段,減少GPU閑置時間。同時結(jié)合16路流水線并行、64路專家并行與ZeRO-1數(shù)據(jù)并行,能顯著降低能耗。

Deepseek還支持FP8混合精度訓(xùn)練,對激活和權(quán)重分別采用Group-wise與Block-wise量化策略,在TensorCore上執(zhí)行高效矩陣運算,減少計算能耗。推理階段通過預(yù)填充與解碼分離策略,優(yōu)化資源分配。

最后是端側(cè)看重的且相比云端更具優(yōu)勢的隱私保護(hù)機制。Deepseek支持完全離線的本地部署模式,用戶數(shù)據(jù)無需上傳云端,避免敏感信息泄露風(fēng)險。

在加密與權(quán)限控制上,Deepseek采用動態(tài)路由策略與冗余專家部署,結(jié)合訪問控制機制,防止模型內(nèi)部數(shù)據(jù)被逆向分析。同時,API服務(wù)支持密鑰管理與用量監(jiān)控,進(jìn)一步保障數(shù)據(jù)安全。

總的來看,Deepseek通過MoE架構(gòu)和MLA注意力機制輕量化得更徹底且性能強勁,比依賴量化后模型體積縮減的TensorFlow Lite和依賴Metal加速與硬件適配的Core ML更靈活效率更高。加之低功耗與隱私保護(hù)方面的增強,這些革新的優(yōu)勢點都是端側(cè)AI亟需的,推動了模型向端側(cè)設(shè)備普及,也為AI落地的多元化需求提供了更優(yōu)解,完全可以說Deepseek正在成為端側(cè)AI的新引擎。

Deepseek帶動端側(cè)AI產(chǎn)業(yè)鏈發(fā)展

Deepseek雖然面世不久,但已經(jīng)成為端側(cè)AI上下游廠商的布局重點。在具體的端側(cè)設(shè)備領(lǐng)域,手機方面包括OPPO、榮耀、魅族等廠商均宣布已經(jīng)完成了對Deepseek模型的接入;汽車圈也開始全面適配,包括吉利、極氪、嵐圖、寶駿、智己、東風(fēng)、零跑、長城等8家車宣布接入Deepseek;PC方面,國產(chǎn)GPU廠商沐曦與聯(lián)想合作推出的Deepseek智能體一體機、英特爾AIPC合作伙伴Flowy在最新版的AIPC助手上率先支持了端側(cè)運行Deepseek模型……終端硬件與Deepseek的融合正在以驚人的速度發(fā)展。

在上游芯片領(lǐng)域,花旗分析師Laura Chen團(tuán)隊在最近的研報中表示,Deepseek的出現(xiàn)推動AI技術(shù)的低成本化和端側(cè)化,將重塑半導(dǎo)體行業(yè)格局。和模型息息相關(guān)的AI芯片產(chǎn)業(yè)鏈,國內(nèi)企業(yè)正紛紛響應(yīng),沐曦、燧原科技、華為昇騰、海光信息、龍芯中科、天數(shù)智芯、壁仞科技、摩爾線程、中星微、云天勵飛等十幾家本土AI芯片廠商均宣布在云端或是端側(cè)適配Deepseek模型。

如華為昇騰已與Deepseek合作,支持Deepseek-R1和Deepseek-V3模型的推理部署;云天勵飛已經(jīng)完成DeepEdge10“算力積木”芯片平臺與Deepseek-R1系列大模型的適配,主攻端側(cè)應(yīng)用;海光信息宣布完成Deepseek V3和R1模型、Deepseek-Janus-Pro多模態(tài)大模型與海光DCU(深度計算單元)的適配;中星微技術(shù)旗下星光智能系列AI芯片也在全面融合Deepseek模型能力向端側(cè)發(fā)力。

在智能硬件中成本占比最高的一環(huán),端側(cè)SoC以及ASIC芯片,隨著Deepseek相關(guān)端側(cè)應(yīng)用爆發(fā),在終端AI部署中的應(yīng)用需求會增加,將迎來更多市場機會。如恒玄科技、瑞芯微、晶晨股份、全志科技、富瀚微、樂鑫科技、中科藍(lán)訊、炬芯科技等公司的SoC芯片,翱捷科技、寒武紀(jì)等公司的端側(cè)ASIC產(chǎn)品都較有代表性。

隨著Deepseek模型在應(yīng)用端的落地,智能終端對存儲芯片的需求同樣強烈。以典型的端側(cè)AI與先進(jìn)存儲技術(shù)代表終端AI手機為例,一部高端機型需要搭載8-12GB的DRAM和128-512GB的NAND Flash。可穿戴市場上對中大NOR Flash容量需求增加也是確定性的趨勢,尤其是中大容量NOR Flash。兆易創(chuàng)新、江波龍、普冉股份、恒爍股份等存儲芯片廠商也在端側(cè)AI時代同樣能一展身手。

模組廠商也在迅速推進(jìn)端側(cè)AI加Deepseek方面的融合,如美格智能正在加速開發(fā)DeepSeek-R1在端側(cè)的落地應(yīng)用,并計劃在2025年推出100TOPS級別的AI模組;廣和通、移遠(yuǎn)通信、潤欣科技、芯訊通等廠商也在推進(jìn)相關(guān)模組產(chǎn)品布局。

移遠(yuǎn)通信已經(jīng)宣布其搭載高通 QCS8550 平臺的邊緣計算模組 SG885G,成功實現(xiàn)了 DeepSeek-R1 蒸餾小模型的穩(wěn)定運行,在成功實現(xiàn) DeepSeek 模型端側(cè)運行;廣和通不久前已官宣高算力 AI 模組及解決方案全面支持小尺寸的 DeepSeek-R1 模型,幫助客戶快速增強終端 AI 推理能力;美格智能正在結(jié)合 AIMO 智能體、高算力 AI 模組的異構(gòu)計算能力,結(jié)合多款模型量化、部署、功耗優(yōu)化 Know-how,加速開發(fā) DeepSeek-R1 模型在端側(cè)落地應(yīng)用及端云結(jié)合整體方案……

端側(cè)AI已經(jīng)成為推動智能設(shè)備革新的核心力量,Deepseek風(fēng)暴為這個即將迎來爆發(fā)的市場向前推進(jìn)推進(jìn)了一大步。端側(cè)AI+Deepseek帶來的終端全面AI正在加速到來,產(chǎn)業(yè)鏈上下游也將在這波浪潮中受益良多。

Deepseek推動端側(cè)AI元年到來,AI模組破局Deepseek在端側(cè)實體產(chǎn)業(yè)落地的最后一公里

回到開頭的問題,當(dāng)AI走出云端落到端側(cè)如何才能讓終端設(shè)備真正“智能”?從目前的端側(cè)應(yīng)用來看,Deepseek正在破解端側(cè)AI落地最后一公里面對著硬件碎片化、模型泛化性、以及端側(cè)能效三個難題。

硬件碎片化即不同端側(cè)設(shè)備如手機、攝像頭、傳感器的算力差異大、架構(gòu)差異大,傳統(tǒng)AI模型難以高效適配統(tǒng)一優(yōu)化。這方面Deepseek帶來的改變已經(jīng)開始顯現(xiàn),首先通過Deepseek蒸餾和量化出來的端側(cè)模型已經(jīng)做到了和硬件無關(guān)的輕量化,支持從超大規(guī)模模型到端側(cè)設(shè)備的無縫擴(kuò)展,解決了一部分端側(cè)場景多層次硬件需求。

其次通過優(yōu)化模型架構(gòu),Deepseek的動態(tài)異構(gòu)計算框架支持端側(cè)芯片內(nèi)多種計算單元的協(xié)同調(diào)度來解決硬件配置碎片化難題。這一方面目前各上游芯片原廠已經(jīng)開始全面推進(jìn)基于Deepseek的軟硬協(xié)同創(chuàng)新,相信后續(xù)出來的端側(cè)芯片能很好地解決不同端側(cè)設(shè)備算力差異大、架構(gòu)差異大的問題。

模型泛化性即傳統(tǒng)模型易受多變的端側(cè)環(huán)境干擾,如何在保證端側(cè)輕量化的同時,讓模型適應(yīng)端側(cè)場景的復(fù)雜多變。Deepseek給出的答卷也很出彩,其跨維度知識蒸餾體系將大模型的邏輯解構(gòu)為思考推理,而非單純知識記憶,再通過動態(tài)權(quán)重分配注入端側(cè)模型。端側(cè)模型雖小但較以往的端側(cè)模型性能更優(yōu),更全面地適配端側(cè)垂直場景。

至于端側(cè)能效,長期以來都是模型算法廠商與端側(cè)硬件設(shè)備廠商在攻克的命題,這需要兩邊長期的軟硬協(xié)同優(yōu)化。Deepseek在算法層面已經(jīng)做了極致的壓縮,如何與硬件做定制化的協(xié)同優(yōu)化就看后續(xù)的適配與迭代了。

Deepseek的出現(xiàn)加速了端側(cè)AI發(fā)展進(jìn)程,而AI模組與Deepseek的融合為端側(cè)實體產(chǎn)業(yè)落地的最后一公里提供了一條破局之道。對于端側(cè)AI產(chǎn)業(yè)鏈下游的終端廠商來說,特別是中小型廠商,如何便捷快速高效地為終端產(chǎn)品賦予本地智能是一道難題。

Deepseek帶動的資本市場熱潮褪去后,落地到真正的實體產(chǎn)業(yè)帶動終端設(shè)備升級與市場增長是下一階段的關(guān)鍵。作為與終端設(shè)備關(guān)系最緊密的中游模組廠商,將AI模組與Deepseek的融合,為下游提供更精準(zhǔn)、更高效的端側(cè)AI產(chǎn)品與服務(wù),為端側(cè)實體產(chǎn)業(yè)落地的難題提供了解題思路。

Deepseek能夠無縫地將大模型的推理能力遷移到更小、更高效的端側(cè)版本中,也能更方便將其融合在智能模組中。像移遠(yuǎn)通信AI模組 SG885G成功實現(xiàn)了 在DeepSeek-R1 蒸餾小模型端側(cè)運行的基礎(chǔ)上,同時完成該模型的針對性微調(diào),提供更精準(zhǔn)、更高效的端側(cè) AI 服務(wù),生成速度超過40Tokens/s,而且還能優(yōu)化。此芯科技在端側(cè)平臺適配的DeepSeek-R1-1.5B模型推理速度接近40Tokens/s,7B模型達(dá)10Tokens/s。這表明端側(cè)模組引入DeepSeek后,在推理速度提升上實現(xiàn)了顯著升級。搭載DeepseekAI模組的端側(cè)AI產(chǎn)品進(jìn)而也能夠承擔(dān)更多計算量,減輕云端服務(wù)器的計算負(fù)擔(dān)。

目前已經(jīng)官宣跑通Deepseek的模組,在應(yīng)用場景覆蓋性很廣,涵蓋智能汽車、機器視覺、PC、機器人、智能家居、AI玩具及可穿戴設(shè)備等多元化場景,多場景應(yīng)用支持讓不同行業(yè)不同終端的下游設(shè)備廠商能夠全面受益于Deepseek帶來的本地智能,加速終端智能化的發(fā)展。

而且模組廠商正在大力推進(jìn)不同算力、功耗的Deepseek模組產(chǎn)品,滿足下游客戶對成本、尺寸的差異化需求。模組針對不同終端應(yīng)用持續(xù)的優(yōu)化將大幅縮短端側(cè)智能相關(guān)產(chǎn)品的落地周期,從而賦能終端側(cè)真正享受到 AI 帶來的收益。

Deepseek在解決了端側(cè)AI硬件碎片化、模型泛化行和效能瓶頸上提供了強大助力,模組與Deepseek的深度結(jié)合更為端側(cè)AI落地最后一公里難題指出了一條破局之道。這條破局之道指向的最終藍(lán)圖,是讓端側(cè)AI成為終端設(shè)備核心功能的定義者,讓終端硬件真正智能起來。

寫在最后

很長一段時間端側(cè)模型都是制約智能終端硬件發(fā)展的枷鎖,而現(xiàn)在DeepSeek的出現(xiàn)讓這種局面開始有所好轉(zhuǎn)。在可預(yù)期的未來里,針對端側(cè)應(yīng)用開發(fā)的Deepseek AI模組將涌現(xiàn),為終端提供便捷高效的AI能力,端側(cè)AI已處在爆發(fā)前夕。